Jednym z problemów, z którym w ostatnich latach zmagają się właściciele stron internetowych, są trudności z indeksowaniem w Google. Materiały w wielu przypadkach nie trafiają do indeksu wyszukiwarki nawet mimo zgłaszania próśb w Google Search Console. Dlaczego tak się dzieje? Jednym z powodów są ograniczone zasoby, jakie roboty Google wykorzystują do analizowania poszczególnych stron. Dowiedz się, czym jest crawl budget, jak go sprawdzić i optymalizować.

Crawl budget – co to?

Aby można było znaleźć daną stronę w wynikach wyszukiwania Google, najpierw musi być zindeksowana. Robot analizuje zawartość danego adresu URL i porządkuje informacje na jego temat, a link ostatecznie trafia do indeksu lub nie. Każda podstrona serwisu jest skanowana osobno, przy czym nie wygląda to tak, że przy odwiedzinach robot Google sprawdzi wszystkie adresy URL w obrębie witryny.

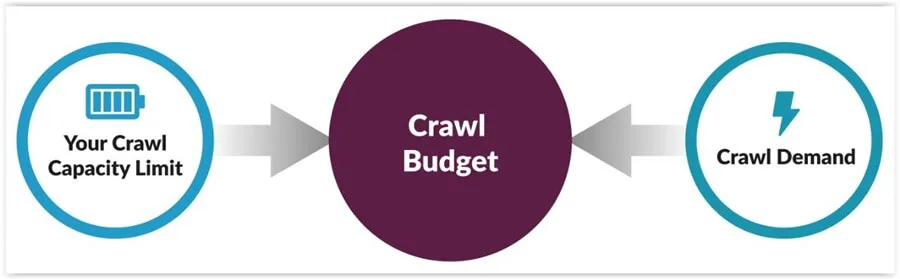

Każda strona ma określony crawl budget (budżet indeksowania). To pojęcie, które jest różnie definiowane. Z informacji w Google Search Central wynika, że to maksymalna ilość czasu i zasobów, jakie robot może poświęcić na indeksowanie jednej witryny. Cześć specjalistów uważa, że to maksymalna liczba stron, które Google może przeskanować w danym czasie lub częstotliwość, z jaką dany serwis może być indeksowany. Więcej na ten temat możesz się dowiedzieć z filmu udostępnionego przez Google.

Jak przebiega proces indeksowania?

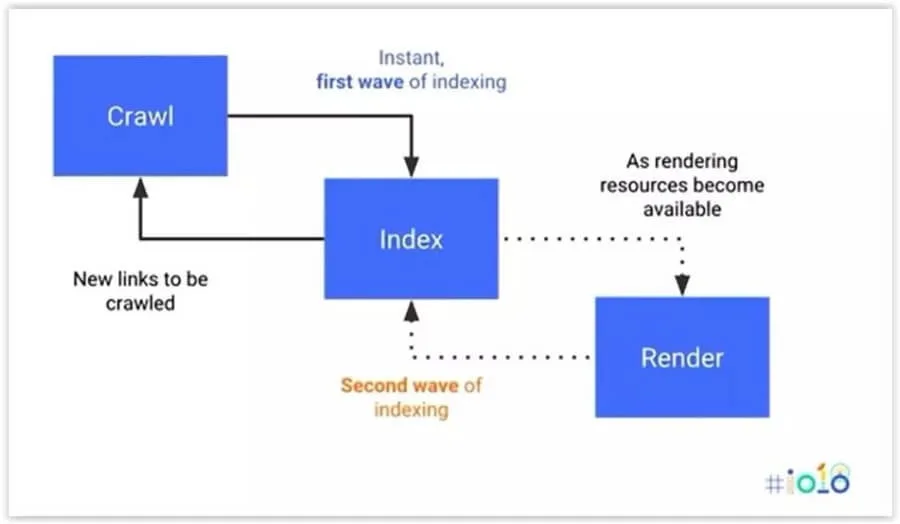

Skoro analizujemy budżet indeksowania, pamiętajmy, jakie kroki wykonuje wyszukiwarka, zanim dany adres URL znajdzie się w indeksie. Według Google proces składa się z 3 etapów:

- Crawling – dotarcie do publicznie dostępnych stron internetowych.

- Indeksowanie – robot analizuje zawartość stron i zapisuje znalezione informacje.

- Wyświetlanie wyników – wyszukiwarka prezentuje najlepiej dopasowane odpowiedzi na zapytanie wysłane przez internautę.

Cały proces obrazuje poniższa grafika. Uwzględnia on również renderowanie, czyli przekształcenie kodu i danych w ostateczną postać, widzialną dla użytkownika.

Czynniki brane pod uwagę przy budżecie indeksowania

Crawl budget zależy co najmniej od kilku czynników. Poprzez odpowiednią optymalizację swojej witryny, możesz spowodować, że roboty Google poświęcą jej więcej czasu i zasobów. Co wpływa na budżet indeksowania?

Crawl rate limit

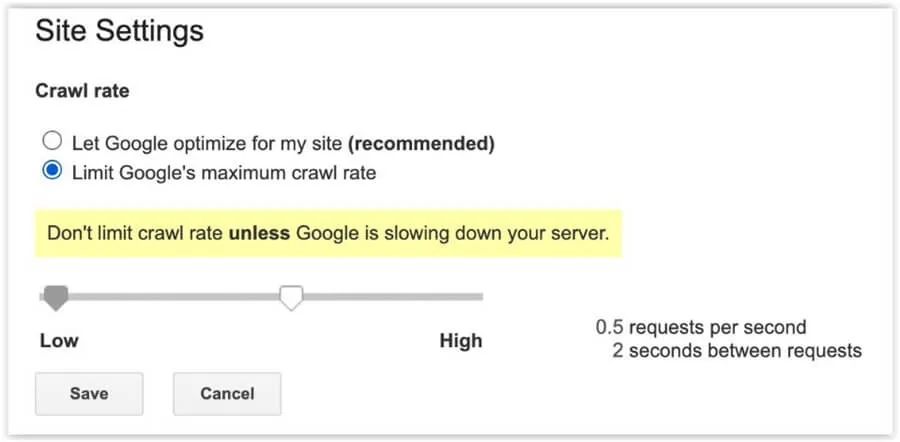

Oznacza on maksymalną liczbę połączeń, jakie może nawiązać robot w trakcie skanowania witryny. Jego celem jest uniknięcie nadmiernego obciążenia strony, które mogłoby powodować negatywne doświadczenia użytkowników serwisu. Google ustala crawl rate limit w zależności od wydajności witryny. Jeśli ładuje się zbyt wolno, to też przydzieli mniejszy limit. Aktywność robotów nie będzie zatem wpływać negatywnie na działanie witryny.

Jeszcze do niedawna można było zmienić crawl rate limit w Google Search Console. 8 stycznia 2024 roku ta opcja przestała być dostępna. Google oceniło, że nie jest już przydatna, ponieważ udoskonalono indeksowanie, a roboty Google nie powodują, że strony będą się dłużej ładować. Narzędzie dawało takie możliwości, jakie widać na poniższej grafice.

Crawl demand

W przypadku crawl rate limit dużą rolę odgrywa wydajność witryny, natomiast w crawl demand – popularność, tzn. liczba odwiedzin, ale nie tylko. Znaczenie ma to, jak wiele dzieje się wokół serwisu. Robot Google chętniej odwiedza strony WWW, które są często klikane w wynikach wyszukiwania. Liczą się także linki prowadzące do konkretnych adresów URL, zatem crawl demand zależy w dużej mierze od Twoich działań. Jeśli inwestujesz w pozycjonowanie, rozwijasz witrynę, pozyskujesz odnośniki, to może zwiększyć crawl budget Twojej witryny.

Crawl health

Ten czynnik wiąże się z crawl rate limit. Kluczowe znaczenie ma w tym przypadku, jak szybko ładują się poszczególne adresy URL. Ważny jest czas odpowiedzi serwera i jego wydajność. Jeśli robot długo będzie oczekiwać na odpowiedź, przełoży się to na mniejszą liczbę zaindeksowanych podstron podczas jednej wizyty. W przypadku gdy witryna działa szybko, do indeksu może trafić więcej adresów URL.

Dlaczego crawl budżet jest tak ważny?

Jeśli dodajesz na stronę kolejny materiał, zależy Ci, aby jak najszybciej znalazł się w indeksie wyszukiwarki Google i pozyskiwał ruch. W przypadku gdy prowadzisz sklep i dodajesz produkty, to od indeksacji zależy, jak szybko internauci będą w stanie go odnaleźć przez wyszukiwarkę. Dlatego crawl budget odgrywa kluczową rolę – szczególnie w przypadku witryn, które składają się z bardzo dużej liczby adresów URL i są często aktualizowane. Jeśli inwestujesz w pozycjonowanie, dbaj o budżet indeksowania. Odpowiednimi działaniami możesz go optymalizować.

Crawl budget jest ważny, gdyż:

- jest potrzebny do indeksowania, czyli pojawienia się danego adresu URL w wynikach wyszukiwania;

- pośrednio wpływa na pozycjonowanie witryny i wyniki sprzedażowe. Jeśli robot Google nie dotrze do danej podstrony, nie weźmie pod uwagę m.in. znajdujących się na niej odnośników wewnętrznych, które odgrywają dużą rolę w widoczności linkowanych adresów URL;

- duża częstotliwość aktualizacji strony wymaga znacznych zasobów robota Google. Crawl budget powinien być wystarczający, aby wyszukiwarka nadążała z indeksowaniem zasobów.

Proces indeksacji stron – jak go sprawdzić?

Żeby analizować indeksację w serwisie, możesz skorzystać z wielu narzędzi. Nie zaniedbuj tego – błędy mogą powodować, że Twoja strona znika z wyników wyszukiwania, a inwestycja w pozycjonowanie się nie zwraca. Jak kontrolować indeksację w witrynie?

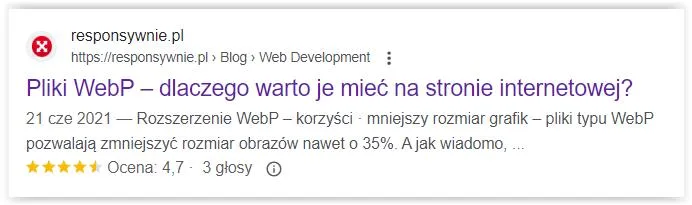

Komenda site: w Google

To szybki sposób, aby sprawdzić, czy dana URL jest zindeksowany. Wystarczy, że wyszukasz frazę site:adrestwojejstrony.pl. W miejscu „adrestwojejstrony.pl” podmień link na swoją stronę. Może to być np.: site:https://responsywnie.pl/pliki-webp/. Ten materiał jest zaindeksowany i Google wyświetliło taki wynik jak na poniższej grafice. Jeśli danego adresu nie ma w indeksie, poproś o indeksację w Google Search Console.

Indeksowanie w Google Search Console

Zaloguj się do GSC, zweryfikuj witrynę, a uzyskasz mnóstwo danych dotyczących widoczności witryny w Google. Wśród nich znajdziesz m.in. statystyki indeksowania. Wybierz opcję Strony.

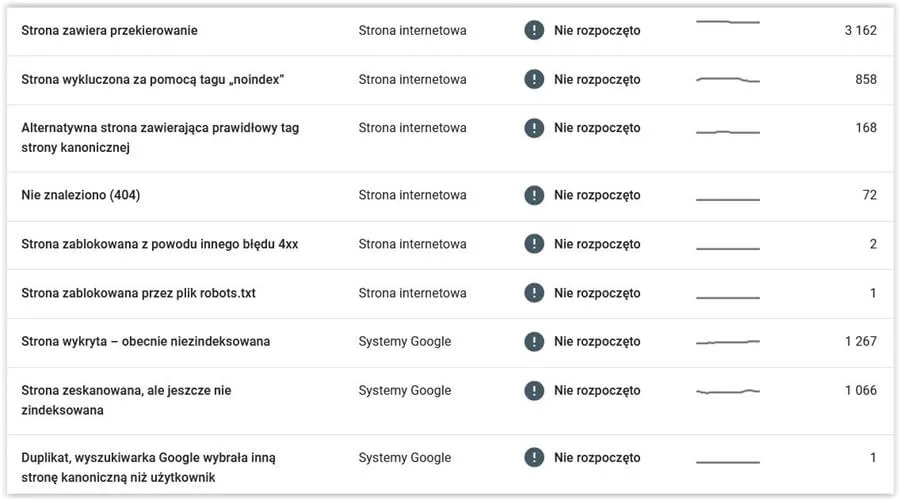

W raporcie znajdziesz informacje o zindeksowanych materiałach, ale przede wszystkim o tych, które nie trafiły do indeksu Google. Znajduje się tam lista przyczyn, a także liczba adresów URL, których dotyczy problem. Mogą one negatywnie wpływać na crawl budget, np. robot Google wykorzystuje swoje zasoby do skanowania adresów, które zwracają błąd. Jeśli pozycjonujesz stronę, regularnie sprawdzaj ten raport. Wskazane tam problemy mogą być przyczyną spadku ruchu, mniejszej widoczności w Google i nieefektywnego wykorzystania crawl budgetu.

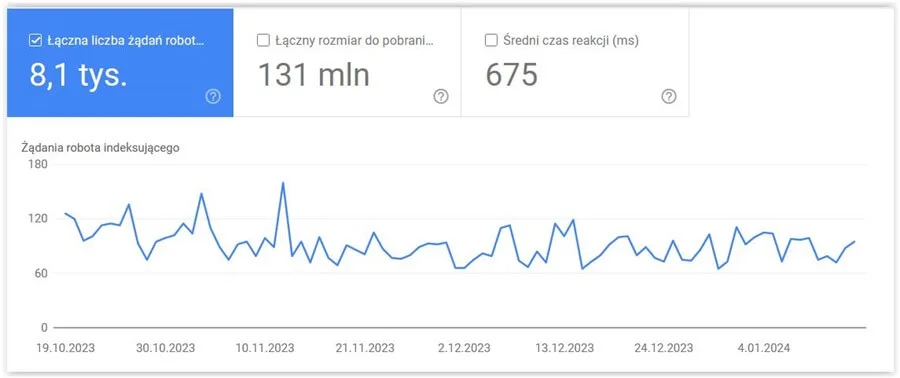

Sprawdź również raport Statystyki indeksowania, który znajdziesz tutaj: https://search.google.com/search-console/settings/crawl-stats. Przykładowy wygląda jak poniżej:

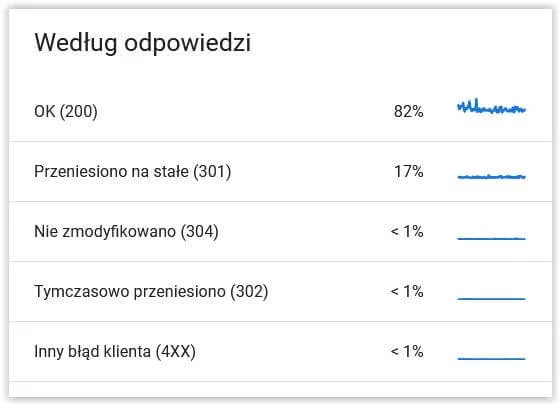

Analizując ten raport, sprawdź Średni czas reakcji. Jeśli nagle się znacznie wydłużył, to może sugerować np. problemy z serwerem. Poniżej raportu znajdziesz kody odpowiedzi. Szczególnie zwróć uwagę na nietypowe, jak np. 304. Prawdopodobnie znajdziesz wśród nich adresy, które nie mają znaczenia dla Twojej strony, a jednak marnujesz na nie crawl budget.

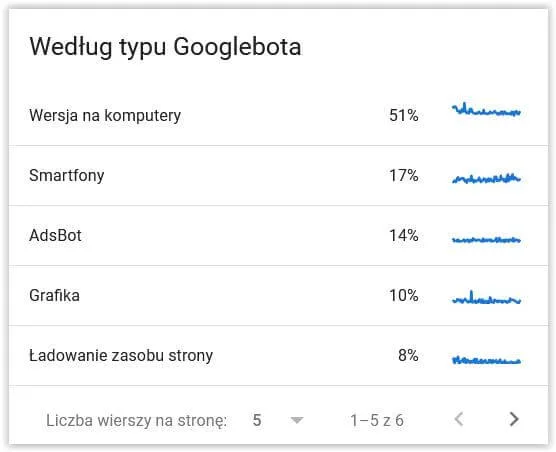

Dużo interesujących danych znajdziesz w raporcie według typu Googlebota. Widać w nim, jaki rodzaj bota wykonuje poszczególne działania.

Ahrefs

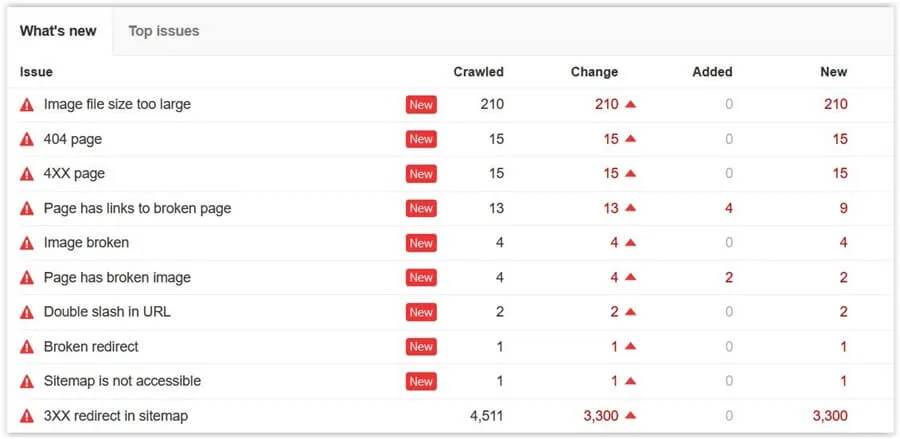

To narzędzie informuje nie tylko o linkach prowadzących do witryny. Przeprowadza również automatyczny audyt serwisu i wskazuje na błędy – w tym związane z indeksowaniem. Dowiesz się z niego m.in. o stronach 404, niedziałających przekierowaniach, przekierowaniach w mapie witryny i innych problemach, które powodują, że crawl budget jest wykorzystywany nieefektywnie.

Zwróć również uwagę na raport dotyczący podlinkowania poszczególnych podstron. Takie adresy URL są prawdopodobnie odwiedzane częściej przez robota Google niż niepodlinkowane podstrony. Warto wykorzystać je do optymalizacji crawl budgetu poprzez umieszczenie linków wewnętrznych do podstron, na których występuje problem z indeksowaniem. Dzięki temu możesz przekierować roboty w głąb serwisu.

Senuto

To narzędzie możesz wykorzystywać do wytypowania stron, które są widoczne na największą liczbę fraz w wynikach wyszukiwania, co oznacza, że mogą mieć wysokie crawl demand. Aby się upewnić, sprawdź logi serwera i ustal, czy rzeczywiście robot Google często odwiedza konkretny adres URL. Dane znajdziesz po zalogowaniu się do panelu zarządzania usługą hostingową, z której korzysta Twoja witryna. Te podstrony serwisu również możesz wykorzystać do podlinkowania URL-i, w przypadku których występuje problem z indeksowaniem.

Narzędzie do analizy logów

Logi są cennym źródłem wiedzy związanej z aktywnością robotów Google na Twojej stronie. Aby jednak ułatwić ich analizowanie, skorzystaj z narzędzia. Jednym z najpopularniejszych jest Screaming Frog Log File Analyzer. Zamieszczony poniżej film pokazuje, jak korzystać z tego narzędzia. Wystarczy przeciągnąć i upuścić plik z logami i rozpocząć analizę. Możesz tak wytypować adresy nieodwiedzane przez roboty Google i takie, które są odwiedzane najczęściej.

Wersja bezpłatna nakłada jednak ograniczenia – program przeanalizuje maksymalnie 1000 linii kodu.

Poprawa crawl budget

Kiedy już ustalisz, jakie problemy z indeksowaniem występują na Twojej stronie, spróbuj je wyeliminować. Możesz zoptymalizować crawl budget różnymi działaniami. Często proste zmiany istotnie wpływają na efekty pozycjonowania strony. Co możesz zrobić?

Przyśpiesz ładowanie strony

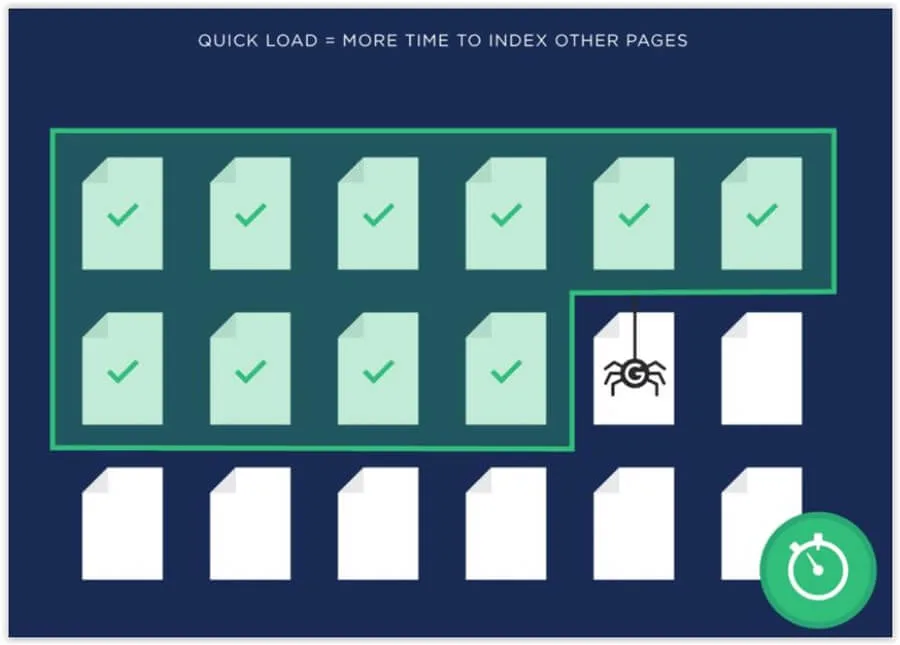

Robot Google poświęci Twojej witrynie określony czas. Jeśli podstrony ładują się szybko, to zdoła dotrzeć do ich większej liczby. Poza tym czas ładowania wpływa na widoczność w Google, a także na konwersję – za optymalizacją witryny pod tym kątem przemawia wiele argumentów.

Zoptymalizuj linkowanie wewnętrzne

Jeśli do danego adresu URL prowadzi wiele odnośników – zewnętrznych i wewnętrznych – prawdopodobnie jest on często odwiedzany przez robota Google. W przypadku gdy witryna składa się z wielu podstron, trudno oczekiwać, że do każdej będzie prowadzić jakiś odnośnik z innej strony. Natomiast w linkowaniu wewnętrznym to kwestia pracy nad optymalizacją witryny. Najlepiej, aby do każdej istotnej podstrony w serwisie prowadziło chociaż kilka linków wewnętrznych.

Poza tym wyszukaj w witrynie odnośniki wewnętrzne, które prowadzą do nieistniejących podstron. Możesz do tego wykorzystać np. Ahrefs. Usuń te błędy, aby nie marnować crawl budgetu.

Unikaj Orphan Pages

Chodzi o podstrony, które nie są podlinkowane w serwisie. Robot Google może do nich nie dotrzeć. Jak wspominaliśmy, każda podstrona, która ma się znaleźć w wynikach wyszukiwania, powinna być podlinkowana z przynajmniej kilku innych.

Wyklucz zduplikowane treści

Google nie chce marnować zasobów na indeksowanie podstron z tą samą treścią. Jeśli znajdziesz takie na Twojej stronie, usuń je albo skorzystaj z przekierowania 301. Dzięki temu optymalnie będziesz wykorzystywać crawl budget. Do szukania takich podstron wykorzystaj np. narzędzie Siteliner.